- 環境

- Windows

- RTX3070

- 手始めに

- https://zenn.dev/fp16/articles/e8c61e2f62e6b6

- インストール、モデル追加

- wsl から linux 版で試すもファイルシステムが read only になってしまった

- 一旦 windows 版で試すことに

- どんな感じ

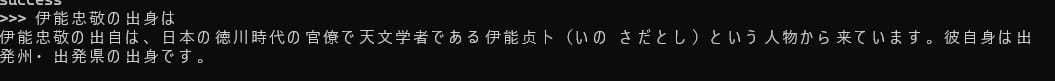

- ollama run(モデル名)でコンソール上から入力できる

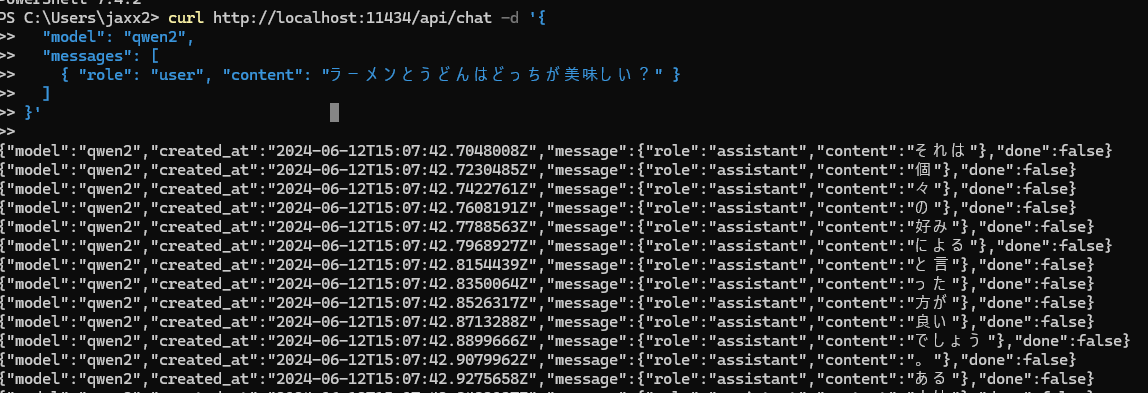

- curl でも入力できる

- モデルをいろいろと試す

- https://ollama.com/library/llama3

- Facebook 製

- https://ollama.com/library/qwen2

- Alibaba 製

- たしかに賢い

- 中国なので NG ワードっぽいこと聞いたが正しく返してくれた

- https://ollama.com/library/dolphin-mixtral

- Gimmie や OpenAI や他モデルと違い 検閲のされていないモデル

- これぞローカル LLM っぽい。使用者の倫理観が問われる

- でも遅い

- https://ollama.com/library/llama3

- ファインチューニング

- ゼロからつくると大変なので既存モデルをチューニングする手法

- TODO WebUI を作るかチャットボット化

- TODO

ローカルLLMを試す

Scrapboximportedscrapbox